DCIM : pensez aux connecteurs !

Source d’erreur : la gestion « manuelle »

Dans un data center, le moindre espace compte. La haute densité fait son entrée dans les salles informatiques à travers les architectures « leaf-spine », car les réseaux 400G ont besoin d’infrastructures très performantes. Les baies doivent accueillir toujours plus de canaux, de fibres et de ports. Les plateformes haute densité sont très demandées.

Comment les opérateurs et les exploitants de centres de données peuvent-ils gérer sans erreurs ces énormes quantités de fibres et de ports ? Comment administrer ces infrastructures toujours plus complexes avec toujours moins de personnel ? Comment garantir la disponibilité de ces réseaux 24 heures sur 24 ? Je me suis souvent posé ces questions ces derniers temps.

L’expérience montre que la gestion « manuelle » est sujette aux erreurs. Les oublis, les inattentions et les malentendus ne sont pas rares. Les conséquences les plus fréquentes : failles de sécurité, pannes, erreurs de brassage, audits erronés, non-respect des règles de compliance.

Vous trouverez une description d’autres risques importants dans l’article Focus de notre magazine spécialisé CONNECTIONS n° 61.

Il est temps de changer de paradigme

Selon une étude de l’institut Uptime, les exploitants de centres de données pourraient éviter près de 75 % des pannes connues en améliorant la gestion, les outils et les processus, et en excluant les sources d’erreurs typiques dans la gestion des câbles et la documentation du réseau.

Un changement de paradigme est désormais indispensable dans la gestion de la couche réseau physique des data centers.

De nombreux outils sont d’ores et déjà disponibles sur le marché, tels que des solutions de gestion des infrastructures de centres de données (Data Center Infrastructure Management, DCIM) et de gestion automatisée des infrastructures (Automated Infrastructure Management, AIM).

Plus ou moins complexes, les DCIM existent en différentes tailles et formes, pour la gestion de bâtiments, d’accès, de l’électricité, de l’alimentation secourue, de la température, de la protection incendie, des ressources, des actifs, du câblage, etc. Certains systèmes sont construits d’un seul tenant, d’autres sont intelligents ou modulaires, mais aucun n’offre une transparence absolue.

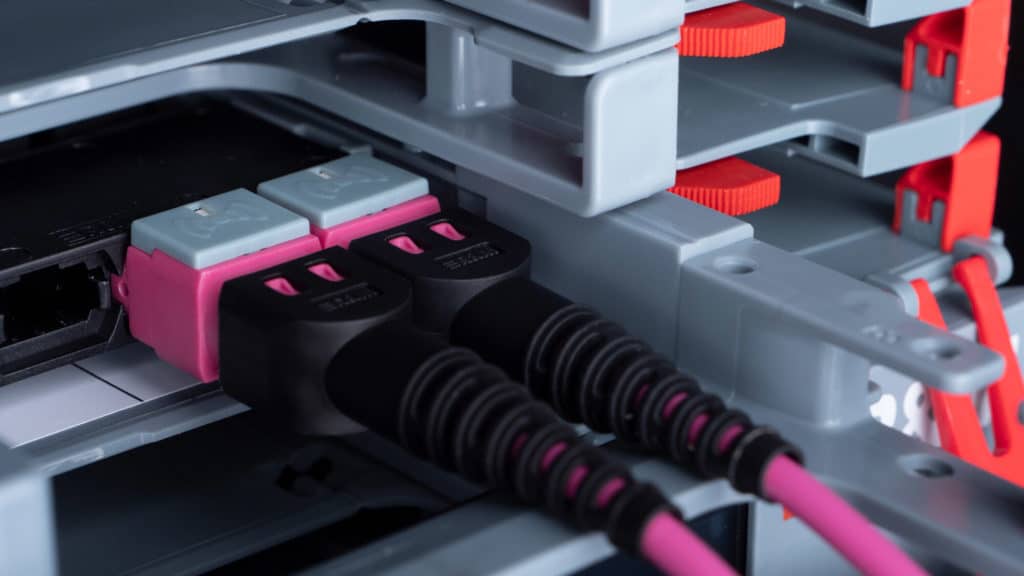

Qui pense gestion des infrastructures, pense rarement au connecteur réseau, alors que ce petit composant non virtualisable peut être déterminant pour la disponibilité de tout un centre de données, voire d’un réseau mondial.

Pour cette raison, R&M propose une nouvelle approche de la sécurité et de la gestion des data centers (DCIM), basée sur la connectivité.

Tout dépend des connecteurs

Le bon fonctionnement du système DCIM lui-même est tributaire de l’exécution correcte du brassage. Que se passerait-il si le tableau de bord DCIM n’affichait pas immédiatement des informations critiques ?

Il faut espérer qu’au moins une connexion LAN redondante soit prévue, mais cela ne change rien au principe : le connecteur est la clé de la disponibilité d’un réseau.

Sans contrôle intégral, de bout en bout, de la couche passive du réseau, il est impossible d’atteindre un haut niveau de sécurité dans un data center.

L’approche de bas en haut pour la DCIM

En résumé, notre approche « bottom up » se présente comme suit :

- Chaque connecteur est muni d’une identification individuelle, unique, passive.

- Les capteurs intelligents au panneau de brassage détectent les connecteurs, les identifient et les attribuent aux ports.

- Les voyants DEL indiquent en temps réel l’état des liaisons actives ainsi que les ordres et les erreurs de brassage, « guidant » ainsi les techniciens.

- Les capteurs communiquent avec un analyseur, qui collecte les informations provenant d’un ou de plusieurs bâtis.

- Tous les analyseurs du système sont reliés au serveur sur place par un réseau Ethernet/IP.

- Le serveur peut consulter l’état d’autres installations à l’aide d’interfaces standardisées, p. ex. SNMP.

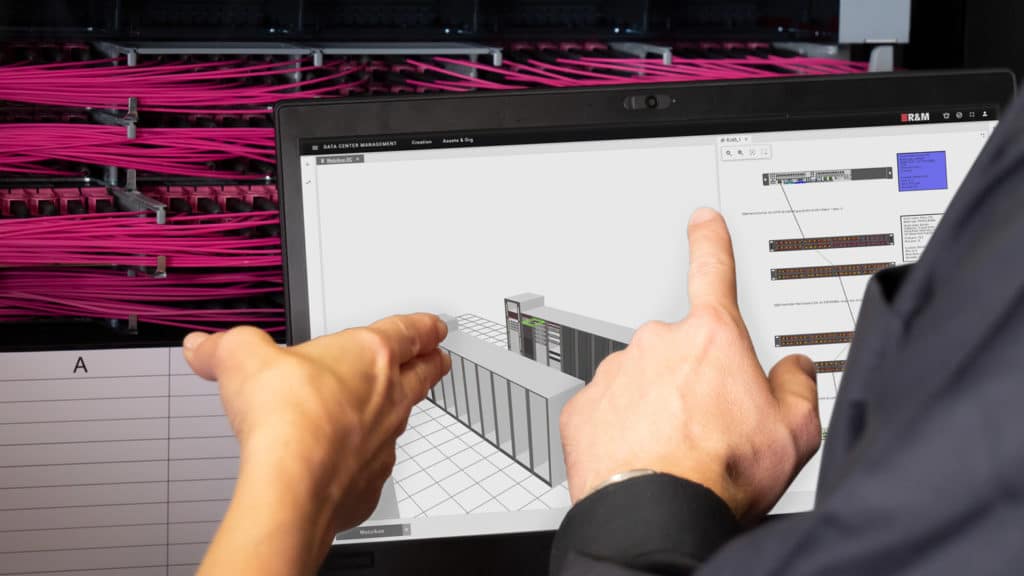

- L’opérateur dispose d’une représentation numérique des salles, de l’inventaire, des bâtis et du câblage. Le serveur assure le traçage, la documentation, la surveillance, les alertes et la communication en temps réel avec les autres systèmes de gestion de l’entreprise.

- Ainsi l’opérateur peut surveiller en permanence et en temps réel l’état de la connectivité physique ainsi que d’autres infrastructures et engager en temps utile d’éventuelles mesures de maintien de la performance.

- Ces outils facilitent le respect des contrats de niveau de service (SLA) et partant, assurent une meilleure satisfaction client.

Les éléments AIM/DCIM présentés ci-dessus forment une chaîne de transmission continue d’informations numériques entre les ports réseau et le tableau de bord de l’opérateur. Aucune connexion n’est « oubliée ». L’attribution des travaux est centralisée et leur exécution, surveillée automatiquement.

Je vous recommande de consulter la page 7 du magazine spécialisé CONNECTIONS n° 61, si vous souhaitez comparer le modèle organique « bottom up » aux approches traditionnelles ou plus complexes de la gestion des infrastructures

Contribution de R&M

R&M propose aux data centers une mise en œuvre aisée du modèle « bottom up » au moyen de ses composants inteliPhy, de son logiciel DCIM inteliPhy net 3.0 et de sa plateforme à très haute densité Netscale.

Il n’est même pas nécessaire de remplacer les panneaux de brassage existants pour les intégrer dans le système DCIM : le service inteliPhy Brownfield aide les exploitants de centres de données à équiper les panneaux de brassage en intelligence, y compris ceux de fabricants tiers. Les opérateurs bénéficient ainsi d’une vue d’ensemble globale, en temps réel, de leur réseau et de sa connectivité.

Logiciel DCIM inteliPhy net 3.0

Avez-vous déjà essayé le logiciel DCIM inteliPhy net 3.0 de R&M ? Demandez dès à présent une version d’essai gratuite. Nous vous enverrons par e-mail les instructions d’installation et un code pour la licence d’essai de 30 jours.