DCIM: Denken Sie an die Stecker!

Fehlerquelle: die «Handarbeit»

Rechenzentren reizen jeden Millimeter aus. Im Computerraum muss Leistung verdichtet werden, um 400G-Netzwerke zu ermöglichen. Leaf-Spine-Architekturen halten Einzug. Racks müssen mehr Kanäle, Fasern und mehr Ports als je zuvor aufnehmen. Der Markt verlangt jetzt nach Plattformen der High-Density-Klasse.

Wie sollen Operator und Rechenzentrumsbetreiber die Masse an Fasern und Ports fehlerfrei managen? Wie meistern sie mit immer weniger Personal die zunehmende Komplexität dieser Infrastrukturen? Wie garantieren sie, dass diese Netzwerke rund um die Uhr sicher verfügbar sind? Diese Fragen habe ich mir in letzter Zeit oft gestellt.

Erfahrungen zeigen, dass sich bei manueller Arbeit immer Fehler einschleichen. Menschen können etwas vergessen, übersehen oder missverstehen. Die häufigsten Folgen: Sicherheitsmängel, Ausfälle, Irrtümer beim Patchen, fehlerhafte Audits, Compliance-Verstösse.

Weitere akute Risiken sind im Fokus-Artikel in unserem Fachmagazin CONNECTIONS No. 61 beschrieben.

Zeit für einen Paradigmenwechsel

Eine Studie des Uptime Institute deutet darauf hin, dass Betreiber von Rechenzentren etwa 75 % der bekannten Ausfälle verhindern könnten. Sie müssten Management, Tools und Prozesse verbessern und typische hausgemachte Fehler beim Kabelmanagement und bei der Netzwerkdokumentation ausschliessen.

In einem Satz: Es ist Zeit für einen Paradigmenwechsel im Management der physischen Netzwerkebene in Rechenzentren.

Der Markt bietet bereits vieles, was dazu benötigt wird, sogenannte Data-Center Infrastructure-Management-(DCIM-) und Automated-Infrastructure-Management-(AIM-)Lösungen.

DCIM gibt es in jeder Form, Grösse und Komplexität. Mit DCIM-Maschinerien lassen sich Gebäude, Zutritt, Elektrizität, USV, Temperatur, Brandschutz, Ressourcen, Assets, Verkabelung und vieles mehr managen. Es gibt allmächtige, hoch intelligente und modulare Angebote. Keines bietet eine bedingungslose Transparenz.

Die wenigsten denken zuerst an den Netzwerkstecker. Dabei entscheidet dieses kleine, nicht virtualisierbare Teil unter Umständen über die Verfügbarkeit eines ganzen Rechenzentrums oder eines weltweiten Netzwerks.

Darum plädieren wir beim R&M dafür, DCIM und Sicherheit von der Konnektivität aus zu betrachten.

Alles hängt von den Steckern ab

Es besteht sogar ein Abhängigkeitsverhältnis. DCIM funktioniert nur, wenn die richtigen Patchkabel im richtigen Port stecken. Was passiert, wenn kritische Informationen nicht unmittelbar auf dem DCIM-Dashboard des Operators erscheinen?

Hoffentlich gibt es mindestens eine redundante LAN-Verbindung, aber sie ändert nichts an der Erkenntnis: Verfügbarkeit fängt beim Stecker an.

Ohne hundertprozentige End-to-End-Kontrolle der passiven Netzwerkebene keine High Security im Rechenzentrum.

Der Bottom-up-Ansatz für DCIM

Unser Bottom-up-Ansatz sieht – knapp beschrieben – folgendermassen aus:

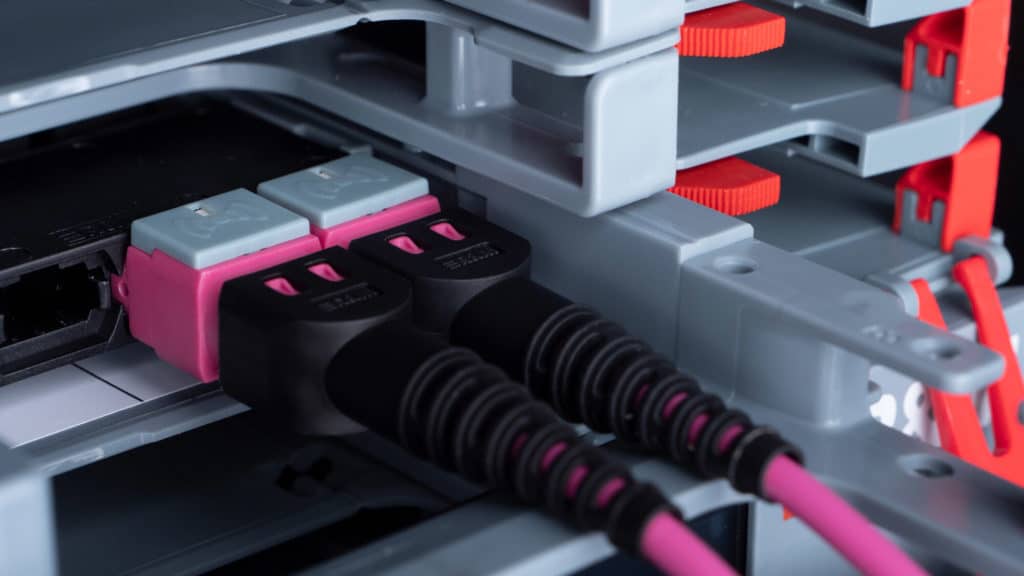

- Jeder Stecker erhält eine eigene, einmalige passive Kennung.

- Sensoren am Rangierfeld «sehen» die Stecker, lesen die Kennungen, ordnen sie den Ports zu. Das ist die Intelligenz an der Steckverbindung.

- LED zeigen aktive Links, Rangieraufträge und Rangierfehler live an. Sie «führen» die Techniker.

- Die Sensorik kommuniziert mit einem Analyzer, der die Verbindungsinformationen von einem oder mehreren Racks bündelt.

- Alle Analyzer in einem System sind über Ethernet/IP mit dem Server vor Ort verbunden.

- Der Status weiterer Installationen kann dem Server über standardisierte Schnittstellen wie SNMP zusätzlich zur Verfügung gestellt werden.

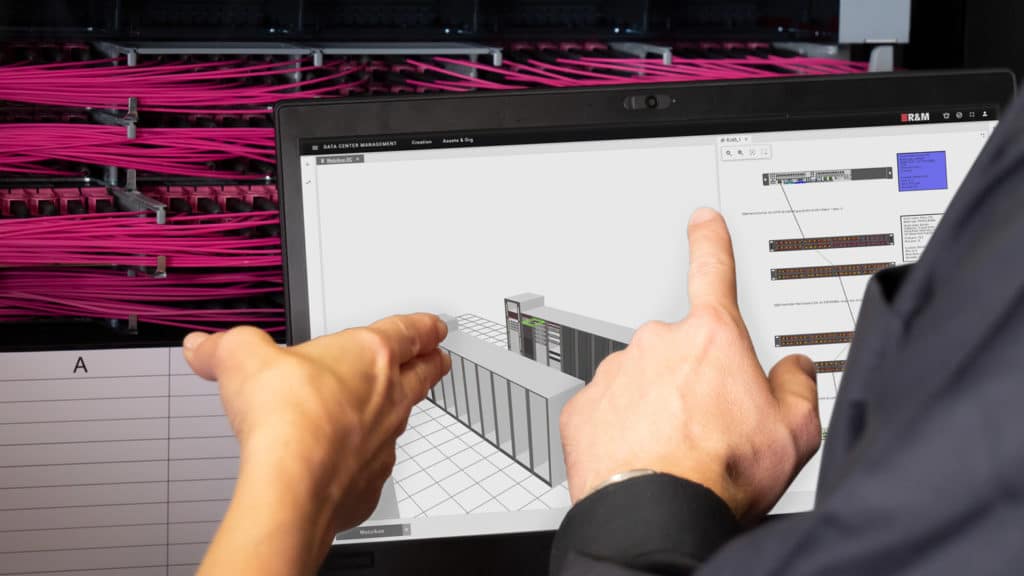

- Der Operator erhält ein digitales Abbild von Räumen, Inventar, Racks und Verkabelung. Der Server trackt, dokumentiert, überwacht, alarmiert und kommuniziert in Echtzeit mit weiteren Managementsystemen im Haus.

- Der Operator kann somit immer in Echtzeit den Zustand der physikalischen Connectivity sowie weiterer Infrastrukturen kontrollieren und notwendige Massnahmen zur Performanceerhaltung rechtzeitig einleiten.

- Die Einhaltung von vertraglich zugesagten SLAs wird damit erleichtert und führt zu einer höheren Kundenzufriedenheit.

Das sind die wesentlichen DCIM-/AIM-Elemente. Von den Ports bis zum Dashboard des Operators entsteht eine ungebrochene digitale Informationskette. Keine Steckverbindung wird mehr «vergessen». Alle Arbeiten werden zentral organisiert und automatisch überwacht.

Wenn Sie das organische Bottom-up-Modell mit den traditionellen oder den komplexen Ansätzen des Infrastrukturmanagements vergleichen wollen, empfehle ich die Lektüre des Fachmagazins CONNECTIONS No. 61, Seite 7.

R&Ms Beitrag

Mit den inteliPhy-Bausteinen, der DCIM-Software inteliPhy net 3.0 und der Ultra-High-Density-Plattform Netscale von R&M können Rechenzentren das Bottom-up-Modell stressfrei umsetzen.

Sie müssen nicht einmal die Rangierfelder wechseln. Der inteliPhy Brownfield Service hilft Betreibern von Rechenzentren, Patchpanel jedes Herstellers «intelligent» zu machen. Damit lassen sie sich in das DCIM einbinden. Operator gewinnen eine ganzheitliche Sicht auf ihr Netzwerk und dessen Connectivity – in Echtzeit.

DCIM-Software inteliPhy net 3.0

Haben Sie die R&Ms DCIM-Software inteliPhy net 3.0 bereits ausprobiert? Fordern Sie gleich eine kostenlose Testversion an. Sie erhalten von uns per E-Mail die Installationsanweisung und einen Testlizenzcode für 30 Tage.